به گزارش ایسنا، در اوایل سال ۱۷۲۶، سفرهای گالیور اثر جاناتان سویفت مفهوم طنز «موتور» را معرفی کرد که یک دستگاه خیالی بود که با جایگذاری مجدد کلمات، ایدههای جدیدی میساخت. در حالی که سوئیفت در زمان خود مورد تمسخر قرار گرفت، اما دیدگاه او در مورد تولید متن الگوریتمی، نشان از کاری داشت که مدلهای زبانی هوش مصنوعی قرنها بعد انجام دادند.

در اوایل دهه ۱۹۰۰، یک مهندس اسپانیایی به نام لئوناردو تورس کوودو (Leonardo Torres y Quevedo)، یک ماشین شطرنجباز به نام ال آجدرسیستا (El Ajedrecista) ساخت که از آهنرباهای الکترومغناطیسی برای اجرای بازی استفاده میکرد. این ماشین میتوانست به طور مستقل حرکات غیرقانونی را تشخیص دهد و در صورت قرار گرفتن در موقعیت برنده، با اطمینان طرف مقابل را مات کند. اگرچه این ماشین مکانیکی بود، اما ال آجدرسیستا نشان داد که چگونه مهندسی هوشمندانه میتواند کاری را شبیهسازی کند که نیاز به درک منطقی دارد و این یک واحد سازنده ضروری برای هوش مصنوعی آینده بود.

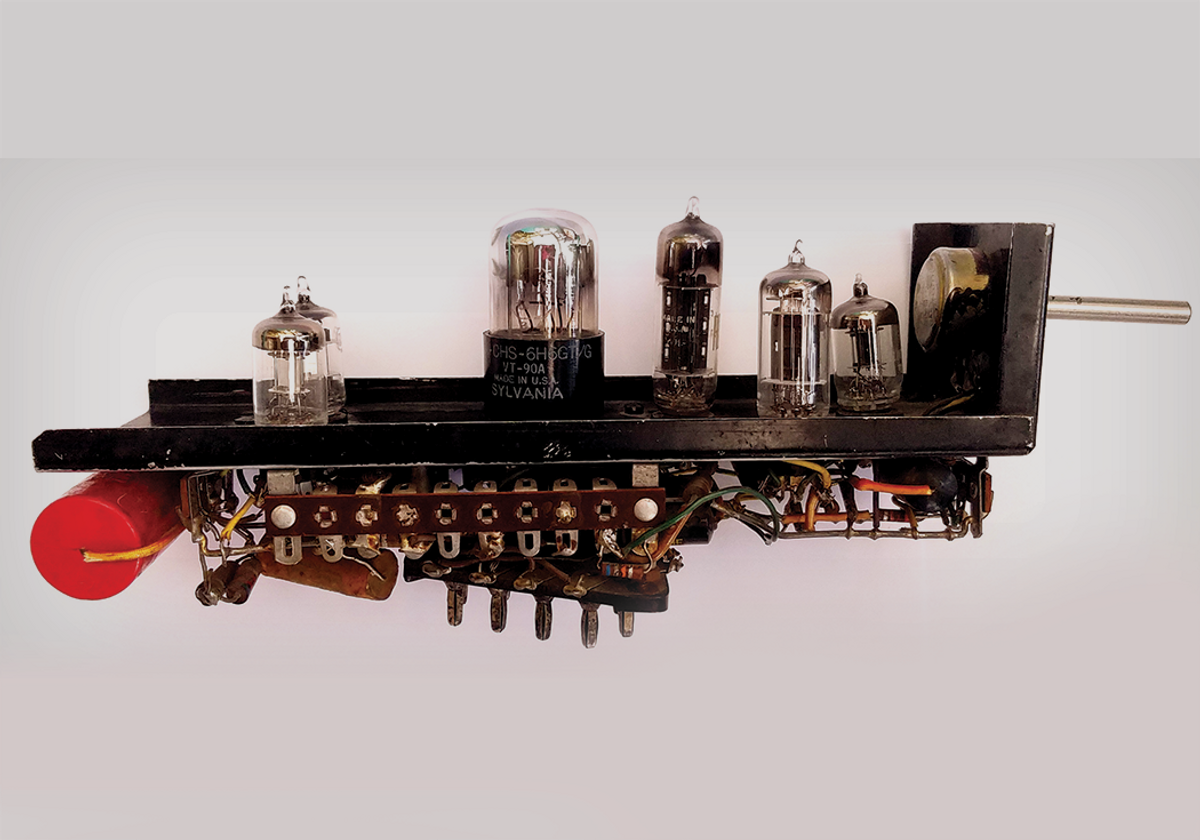

در دهه ۱۹۴۰، توسعه رایانههای الکترونیکی دیجیتال باعث تغییر شکل فرضیات ما در مورد آنچه ماشینها میتوانند انجام دهند، شد. جان وینسنت اتاناسوف (John Vincent Atanasoff) و کلیفورد بری (Clifford Berry)، رایانه اتاناسوف-بری (ABC) را معرفی کردند که محاسبات باینری و مدارهای الکترونیکی را معرفی میکرد. اینها سخت افزارهای حیاتی هستند که پایه و اساسی برای برنامههای هوش مصنوعی آینده شدند.

در سال ۱۹۴۳، وارن مککالوچ (Warren McCulloch) و والتر پیتس (Walter Pitts) مقاله پیشگام خود را با عنوان «حساب منطقی ایدههای ماندگار در فعالیت عصبی» منتشر کردند که پیشنهاد میکرد مغز را میتوان یک شبکه محاسباتی در نظر گرفت. این ایده برای مدلسازی نورونها و سیناپسها بهصورت ریاضی، منجر به دههها تحقیق در حوزه شبکههای عصبی شد که حوزهای از هوش مصنوعی است که در نهایت این حوزه را در قرن بیست و یکم دوباره سر زبانها انداخت.

آلن تورینگ، نابغه ریاضی میپرسد: آیا ماشینها میتوانند فکر کنند؟

نام هیچ چهرهای بیشتر از آلن تورینگ در گفتگو در مورد ریشههای مفهومی هوش مصنوعی به چشم نمیخورد. تورینگ در سال ۱۹۱۲ متولد شد و یک ریاضیدان بریتانیایی بود که فعالیتش زمینهساز علوم رایانه مدرن شد. در سال ۱۹۵۰، او «ماشینهای محاسباتی و هوش» را منتشر کرد، مقالهای که مستقیما به طرح این سؤال پرداخت: آیا ماشینها میتوانند فکر کنند؟

تورینگ به جای غوطهور شدن در بحثهای متافیزیکی، یک آزمون عملیاتی را پیشنهاد کرد که بعدها آزمون تورینگ نام گرفت. در این آزمون، یک ارزیابی کننده انسانی درگیر مکالمهای متنی با یک مخاطب غایب میشود که میتواند انسان یا ماشین باشد. اگر شخص ارزیابی کننده نتواند به طور قابل اعتماد تشخیص دهد که کدام ماشین و کدام انسان واقعی است، در این صورت، طبق تعریف عملیاتی تورینگ، ماشین میتواند «هوشمند» تلقی شود.

این رویکرد به چند دلیل متحول کننده بود. اول اینکه با تمرکز بر عملکرد، از تعاریف مبهم «تفکر» فاصله میگرفت. دوم اینکه، درک و تولید زبان را به عنوان شاخصهای کلیدی هوش، نمایان میکرد و سوم اینکه آزمون تورینگ به معیاری محبوب در آزمایشگاههای تحقیقاتی و داستانهای علمی تخیلی تبدیل شد و نحوه درک افراد خارج از این حوزه را شکل داد.

تاثیر تورینگ بر هوش مصنوعی فراتر از آزمایش بود. کار گستردهتر او در مورد محاسباتپذیری، سیستمهای رسمی و رمزنگاری، زمینه را برای اندیشیدن به رایانه بهعنوان یک «ماشین جهانی» فراهم کرد که در اصل میتواند هر کاری را با دستورات درست انجام دهد. او در سال ۱۹۵۴ درگذشت و هرگز شاهد اصطلاح «هوش مصنوعی» به طور رسمی نبود، اما اثری که او بر این زمینه گذاشت، پاک نشدنی است.

جان مک کارتی: مردی که «هوش مصنوعی» را ابداع کرد

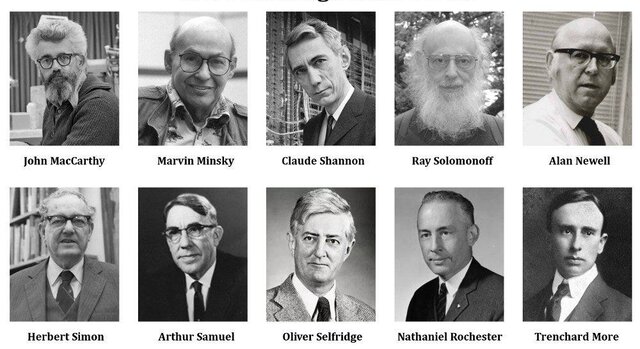

اگر تورینگ بذرهای مفهومی این کار را کاشته بود، جان مک کارتی به آنها کمک میکرد تا در یک رشته رسمی رشد کنند. مک کارتی، ریاضیدان و دانشمند رایانه در کالج دارتموث، سازماندهنده اصلی پروژه تحقیقاتی تابستانی دارتموث در سال ۱۹۵۶ در زمینه هوش مصنوعی بود؛ پروژهای که اکنون به عنوان زادگاه رسمی هوش مصنوعی به عنوان یک رشته شناخته میشود.

در سال ۱۹۵۵، مک کارتی به همراه ماروین مینسکی (Marvin Minsky)، کلود شانون (Claude Shannon) و ناتانیل روچستر (Nathaniel Rochester) پیشنهادی را برای یک کارگاه تابستانی در کالج دارتموث ارائه کردند. در این پیشنهاد برای اولین بار از اصطلاح «هوش مصنوعی» استفاده شد. جاه طلبی آنها ساده و در عین حال جسورانه بود. متفکران برجسته را گرد همآورید تا ببینید آیا میتوان ماشینهایی را برای شبیهسازی هوش در سطح انسان ساخت یا خیر.

اگرچه این کنفرانس به یک «پدیده نو» منجر نشد، اما در لحظه، ذهنهای روشنی را جذب کرد که دستور کار تحقیقاتی اولیه هوش مصنوعی را ایجاد کردند. کمکهای مک کارتی به همین جا ختم نشد. او در طول حرفه پربار خود، لیسپ Lisp را در سال ۱۹۵۸ توسعه داد که یک زبان برنامهنویسی است که به سرعت به زبان تحقیقات هوش مصنوعی برای دههها تبدیل شد.

تاثیر تورینگ بر هوش مصنوعی فراتر از آزمایش بود. او در سال ۱۹۵۴ درگذشت و هرگز شاهد اصطلاح «هوش مصنوعی» به طور رسمی نبود، اما اثری که او بر این زمینه گذاشت، فراموش نشدنی است.

مک کارتی معتقد بود که رایانهها باید با استفاده از منطق رسمی و روشهای مبتنی بر دانش درباره جهان استدلال کنند؛ رویکردی که اغلب با کسانی که مسیر زیستیتر و الهامگرفته از مغز را ترجیح میدهند، در تضاد است. صرف نظر از رویکرد، نام مک کارتی برای همیشه با شروع رسمی هوش مصنوعی به عنوان یک زمینه تحقیقاتی گره خورده است.

ماروین مینسکی: پل زدن بین روانشناسی و محاسبات

ماروین مینسکی (Marvin Minsky)، یکی دیگر از سازماندهندگان کلیدی کارگاه آموزشی دارتموث، استاد دانشگاه مؤسسه فناوری ماساچوست بود که مفاهیمی از روانشناسی، ریاضیات و علوم رایانه ادغام کرد. در سال ۱۹۵۱، مینسکی در کنار دین ادموندز (Dean Edmunds)، ماشین حساب تقویتی آنالوگ عصبی تصادفی (SNARC) را ایجاد کرد که اولین ماشین شبکه عصبی مصنوعی در نظر گرفته شد. این دستگاهی بود که با استفاده از ۳۰۰۰ لوله خلأ و وزنههای سیناپسی که میتوانستند از طریق پاداشها و تنبیههای شبیهسازیشده تنظیم شوند، تلاش میکرد تا نحوه یادگیری یک موش در مارپیچ را شبیهسازی کند.

مطالعات اولیه مینسکی حاکی از کنجکاوی عمیق او در یادگیری الهام گرفته از زیستشناسی بود. با این حال، با پیشرفت این رشته، او به منتقد سرسخت مدلهای پرسپترون ساده (Perceptrons) تبدیل شد و به محدودیتهای اساسی آنها در انجام وظایف پیچیدهتر اشاره کرد. این نقد در کتابی با همین نام در سال ۱۹۶۹ مستند شد که به طور مؤثری شور و شوق تحقیقاتی در مورد شبکههای عصبی را در دهه ۱۹۷۰ کاهش داد و تا حدی از آن به عنوان «زمستان هوش مصنوعی» یاد میشود.

با این حال، ماروین مینسکی صرفا یک منتقد نبود. کار گستردهتر او نحوه تفکر محققان در مورد هوش و معماری شناختی را شکل داد. او از نظریه جامعه ذهن دفاع کرد و پیشنهاد کرد که هوش از مجموعهای از عوامل تخصصی که به طور موازی کار میکنند، پدیدار میشود. او همچنین به تاسیس آزمایشگاه هوش مصنوعی مؤسسه فناوری ماساچوست که در حال حاضر آزمایشگاه علوم رایانه و هوش مصنوعی نام دارد، کمک کرد؛ جایی که بسیاری از محققان پیشگام هوش مصنوعی در آن شروع به کار کردند.

تنش بین شبکههای عصبی الهام گرفته از زیستشناسی و هوش مصنوعی نمادین، هسته اصلی بسیاری از بحثها در دهههای بعدی بود.

هربرت سیمون و آلن نیوول: پیشگامان ماشینهای حل مساله

در حالی که مک کارتی و مینسکی هوش مصنوعی را از نقطه نظر منطق و محاسبات تعریف کردند، هربرت آ. سیمون (Herbert A. Simon) که یک دانشمند علوم سیاسی بود و بعدها برنده جایزه نوبل اقتصاد شد و آلن نیول (Allen Newell) که ریاضیدان و دانشمند رایانه بود، با تمرکز بر فرآیندهای حل مساله و شناختی به هوش مصنوعی نزدیک شدند. همکاری آنها در دانشگاه کارنگی ملون دو مورد از اولین برنامههای هوش مصنوعی را به همراه داشت.

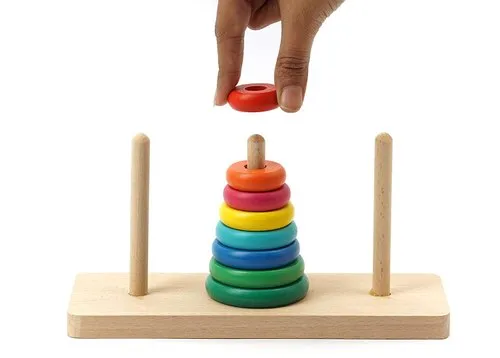

«نظریهپرداز منطقی» (Logic Theorist) که اغلب به عنوان اولین برنامه کاربردی هوش مصنوعی در نظر گرفته میشود، ۳۸ قضیه از ۵۲ قضیه اول را در مبادی ریاضیات Principia Mathematica اثبات کرد. حلّال مسائل عمومی (۱۹۵۷)، دنبالهای که سعی در تقلید گستردهتر از استراتژیهای حل مساله انسانی، مدلسازی وظایفی مانند رمزنگاری و پازل برج هانوی داشت، نیز به دنبال آن آمد.

سیمون و نیول معتقد بودند که میتوانند با شناسایی نحوه برخورد انسانها با حل مساله، رایانهها را برای انجام همین کار برنامهریزی کنند. موضع بین رشتهای آنها روانشناسی شناختی، علوم رایانه و نظریه سازمانی را برای بررسی چگونگی بازنمایی، جستجو و کاربرد دانش ترکیب کرد.

آنها مفاهیم اکتشافی، قوانین سرانگشتی یا استراتژیهایی را معرفی کردند که به ماشین اجازه میدهد فضاهای جستجوی بزرگ را هرس کند و راهحلهای کارآمدتری پیدا کند. با همه خوشبینی آن دوران، سیمون پیشبینی کرد که ماشینها به زودی میتوانند «هر کاری را که یک انسان میتواند انجام دهد» انجام دهند.

آرتور ساموئل: آموزش ماشینها برای یادگیری

عبارت یادگیری ماشینی امروزه به قدری رایج است که ممکن است شبیه به یک اختراع مدرن باشد. یکی از محققان به نام آرتور ساموئل (Arthur Samuel)، اولین بار در اواخر دهه ۱۹۵۰ آن را رایج کرد. کار ساموئل ایجاد یک برنامه بازی بود که از اشتباهاتش درس میگرفت. او برنامه را با انجام هزاران بازی علیه خودش توسعه داد. برنامه بهبود یافت و در نهایت از سطح مهارت ساموئل پیشی گرفت. او همچنین روی مفاهیم یادگیری تقویتی کار کرد. رویکرد او شامل یک تابع امتیازدهی بود.

برنامه ساموئل نه تنها یک نوآوری بود، بلکه یک نمایش واضح از این بود که رایانهها میتوانند عملکرد خود را در طول زمان از طریق تجربه تکامل دهند. امروزه، این روش در همه چیز، از سیستمهای توصیهگر گرفته تا یادگیری تقویتی عمیق مدرن که در محیطهای پیچیده اعمال میشوند، دیده میشود.

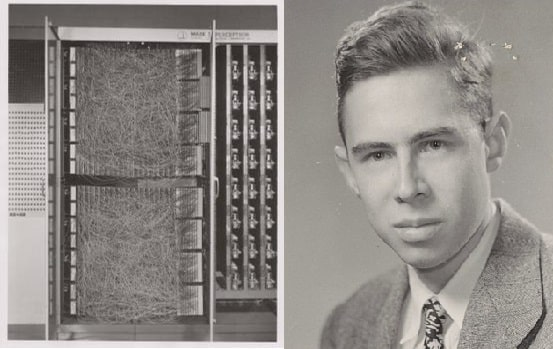

فرانک روزنبلات: پرسپترون یک انقلاب شبکه عصبی را آغاز میکند

در حالی که مینسکی به محدودیتهای معماریهای عصبی ساده اشاره کرد، فرانک روزنبلات پرسپترون را در سال ۱۹۵۷ معرفی کرد. پرسپترون یک شبکه دو لایه با وزنهای قابل تنظیم بود که میتوانست هنگام آموزش بر روی نمونههای برچسبگذاری شده، طبقهبندی ورودیها را بیاموزد. چشمانداز روزنبلات این بود که پرسپترون به سیستمی تبدیل شود که قادر به انجام وظایف پیچیدهتری مانند تشخیص تصویر است.

در سال ۱۹۵۸، روزنبلات بودجهای را از نیروی دریایی ایالات متحده برای ساخت نسخه سختافزاری پرسپترون تامین کرد. آزمایشهای اولیه نشان داد که پرسپترونها میتوانند حروف خاصی از الفبا را تشخیص دهند و این در آن زمان هیجانانگیز بود که ماشینها ممکن است به زودی بتوانند قابلیت بینایی انسان در تمایز قائل شدن بین اجسام رقابت کنند.

پسانتشار یا انتشارمعکوس، روشی در یادگیری عمیق برای آموزش شبکههای عصبی است.

با این حال، پرسپترون محدود به حل مسائل خطی قابل تفکیک بود که باعث انتقاد مینسکی و پیپرت در سال ۱۹۶۹ شد. حوزه شبکههای عصبی نزدیک به دو دهه در سایه این انتقادات با مشکل مواجه شد. با این حال، پرسپترون روزنبلات یک نقطه عطف حیاتی با تجسم اولیه این ایده بود که رایانهها میتوانند موارد ارائه شده را مستقیما از روی دادهها یاد بگیرند. این مفهوم در اواخر دهه ۱۹۸۰ با اختراع و متداول شدن روشی در یادگیری عمیق موسوم به «پسانتشار» (Backpropagation) بار دیگر قدرتمندانه ظهور کرد و در نهایت به موج یادگیری عمیق چندین دهه بعد منجر شد.

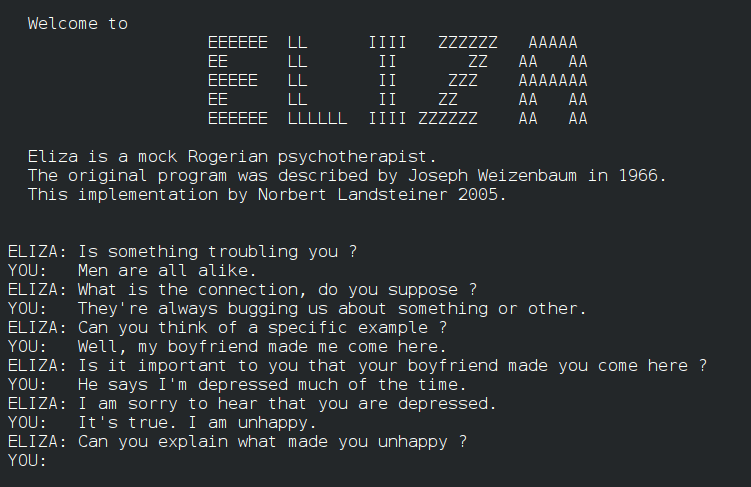

جوزف وایزنبام: خالق اولیه چتباتها

یکی از افراد پیشگام در پردازش زبان طبیعی، جوزف وایزنباوم بود که برنامه معروف الایزا (ELIZA) را در اواسط دهه ۱۹۶۰ توسعه داد. الایزا با پاسخ دادن به ورودی تایپ شده با اسکریپتهای ساده و منطبق با الگو، مکالمه انسانی را شبیهسازی کرد.

الایزا که تا حدی برای انتقاد از ارتباطات سطحی انسان و رایانه طراحی شده بود، باعث غافلگیری وایزنباوم شد، هنگامی که کاربران احساسات واقعی و همدلی را به برنامه نسبت دادند. الایزا نقطه عطف مهمی است که امکانات و پیچیدگیهای اخلاقی طراحی ماشینهایی را نشان میدهد که در گفتگوهای ظاهرا شبیه به انسان شرکت میکنند. وایزنبام همچنین به منتقد مهم دیدگاههای بیش از حد خوشبینانه در مورد هوش مصنوعی تبدیل شد و هشدار داد که جامعه باید از پیامدهای اخلاقی ساخت چنین سیستمهایی آگاه باشد.

از هیجان تا زمستان: چرخههای اولیه هوش مصنوعی

دهههای ۱۹۶۰ و ۱۹۷۰ اولین عصر طلایی هوش مصنوعی بود: محققان مؤسسه فناوری ماساچوست، کارنگی ملون، استنفورد و سایر مؤسسات با همه چیز از رباتیک گرفته تا سامانههای خُبره (expert system) دست و پنجه نرم کردند. خوشبینی در آن زمان به اوج خود رسید و با بودجههای قوی و سرفصلهایی که نوید این را میدادند که ساخت ماشینهایی با هوش در سطح انسانی نزدیک به وقوع است، افزایش یافت. با این حال، دو زمستان بر سر راه این جشن هوشمصنوعی قرار گرفت.

سامانههای خُبره (expert system) به دستهای خاص از نرمافزارهای رایانهای گفته میشود که در راستای کمک به کاردانان و متخصصان انسانی یا جایگزینی جزئی آنان در زمینههای محدود تخصصی تلاش دارند. اینگونه سامانهها، در واقع، نمونههای آغازین و سادهتری از فناوری پیشرفتهتر سامانههای دانش-بنیان بهشمار میآیند.

در دهه ۱۹۷۰، در زمستان هوش مصنوعی، به دنبال سرخوردگی عمومی از وعدههای ناقص، بودجه در ایالات متحده و بریتانیا محدود شد. پیشرفت در هوش مصنوعی نمادین کُند شد، این اتفاق بهویژه در زمانی رخ داد که آزمایشگاههای تحقیقاتی تمرکز خود را تغییر دادند یا تعطیل شدند.

زمستان هوش مصنوعی اواخر دهه ۱۹۸۰ پس از رونق سیستمهای پیشرفته یا سامانههای خُبره در اوایل دهه ۱۹۸۰ فرا رسید و تبلیغات بیش از حد دوباره منجر به ناامیدی و کاهش بودجه شد.

با وجود این عقبنشینیها، بذرهای کاشته شده توسط تورینگ، مک کارتی، مینسکی، نیول، سایمون، ساموئل و روزنبلات به آرامی به رشد خود ادامه دادند. پیشرفتهای کلیدی در روش «پس انتشار» و ظهور سخت افزارهای قدرتمندتر، زمینه را برای تولدی دوباره در شبکههای عصبی در اواخر دهه ۱۹۹۰ و اوایل دهه ۲۰۰۰ فراهم کرد.

نگاهی اجمالی به مبتکران جدید

اگرچه پیشگامان اولیهای که در مورد آنها صحبت کردیم، چارچوب مفهومی هوش مصنوعی را تثبیت کردند، مسیر این رشته در دهههای ۱۹۸۰، ۱۹۹۰ و اوایل دهه ۲۰۰۰، افراد برجسته جدیدی را نیز معرفی کرد. جودیا پرل (Judea Pearl) از شبکههای بیزی را معرفی کرد و مدلسازی عدم قطعیت را به سیستمهای هوش مصنوعی آورد. جفری هینتون (Geoffrey Hinton)، یان لیکان (Yann LeCun) و یوشوا بنجیو (Yoshua Bengio) شبکههای عصبی را از طریق روشهای یادگیری عمیق احیا کردند.

گروه هینتون در دانشگاه تورنتو در سال ۲۰۱۲ با یک شبکه عصبی پیچیده عمیق که روشهای سنتی در تشخیص تصویر را درهم میشکست، جهان را شگفتزده کردند. این داستان از موفقیت، ظهور غیرقابل توقف یادگیری عمیق را رقم زد.

از جنبه تجاری، شطرنجباز رایانهای دیپ بلو متعلق به شرکت بینالمللی دستگاههای کسبوکار آیبیام (IBM) در سال ۱۹۹۷ استاد بزرگ شطرنج، گری کاسپاروف (Garry Kasparov) را شکست داد و ثابت کرد که با سختافزارهای تخصصی و الگوریتمهای جستجوی پیچیده، ماشینها میتوانند حتی با استعدادترین انسانها را در یک بازی استراتژیک محبوب به بهترین شکل ممکن شکست دهند.

پیشرفت سریع ادامه یافت، زیرا برنامه رایانهای آلفاگو متعلق به دیپمایند (AlphaGo) قهرمان جهان را در بازی قدیمی Go در سال ۲۰۱۶ شکست داد. مدلهای زبانی پیشرفته مانند جیپیتی-۳ از اُپنایآی تولید متون شگفتانگیز و تواناییهای یادگیری را نشان دادند. گسترش هوش مصنوعی به اپلیکیشنهای روزمره مانند دستیارهای صوتی، سیستمهای پیشنهادات و تولید خودکار محتوا قدم بعدی بود.

این پیشرفتها در نتیجه پرسشها و روششناسیهای اساسی معرفیشده توسط پدران بنیانگذار هوش مصنوعی شکل گرفتهاند. در حالی که در اینجا قرار نیست به طور اساسی به این دستاوردهای مدرن بپردازیم، اما مهم است که بدانیم تمام این شگفتیهای هوش مصنوعی قرن بیست و یکم بر پایهای است که توسط تورینگ، مک کارتی، مینسکی، سایمون، نیول، ساموئل، روزنبلات و همتایان آنها بنا نهاده شدهاند.

چرا نوآوران اولیه هوش مصنوعی برای ما اهمیت دارند؟

ممکن است از خود بپرسید که چرا دانستن این ارقام و اطلاعات اولیه هنوز اهمیت دارد، با توجه به اینکه هوش مصنوعی با خوشههای محاسباتی عظیم، دادههای بزرگ و چارچوبهای یادگیری عمیق تغییر کرده است. پاسخ در اصولی است که آنها پایهگذاری کردند.

رویکرد عملگرایانه تورینگ، بر نحوه ارزیابی هوش مصنوعی امروزی، از چتباتها گرفته تا سیستمهای تشخیص گفتار، تاثیر گذاشت. تاکید مک کارتی بر منطق رسمی و بازنمایی دانش در بسیاری از زیرشاخههای هوش مصنوعی، مانند استدلال خودکار، برنامهریزی و نمودارهای دانش محور باقی میماند. چشمانداز شبکه عصبی از مک کالوچ و پیتس تا روزنبلات تا یادگیری عمیق مدرن، بر اساس این ایده است که میتوانیم جنبههای مختلف مغز انسان را به صورت محاسباتی مدلسازی کنیم.

تاکید نیوول و سایمون بر جستجو و اکتشاف، الگویی برای الگوریتمهایی است که به سرعت از فضای راه حلهای پیچیده عبور میکنند. برنامه جستجوگر آرتور ساموئل از ظهور رویکردهای داده محور خبر داد. امروزه، بیشتر داستانهای موفقیت هوش مصنوعی به الگوهای یادگیری به دست آمده از مجموعه دادههای عظیم وابسته است.

بسیاری از مناقشات اولیه هنوز هم امروزه تکرار میشوند، بهویژه بحث نمادین هوش مصنوعی در مقابل شبکه عصبی یا این سؤال که چگونه میتوان دانش را به بهترین نحو بازنمایی و دستکاری کرد. جدا از اصلاحات فناورانه، تنشهای اساسی همچنان نیرویی پویا هستند که نوآوریهای بیشتر را تحریک میکنند.

هوش مصنوعی مدرن به طور خلاصه: سوار بر موج

در حالی که بخش عمدهای از این گزارش بر اولین نوآوران متمرکز بود، ارائه یک تصویر کوتاه از چگونگی ادامه موج در حال تکامل هوش مصنوعی نیز مفید خواهد بود.

رنسانس یادگیری عمیق (۲۰۰۶-۲۰۱۲): محققانی مانند جفری هینتون، یان لیکان و اندرو انجی از قدرت پسانتشار و واحد پردازش گرافیکی استفاده کردند که منجر به پیشرفتهایی در بینایی رایانه (ImageNet)، تشخیص گفتار و موارد دیگر شد.

رشد شتابان (۲۰۱۲-۲۰۲۰): غولهای فناوری مانند گوگل، فیس بوک، آیبیام، مایکروسافت و اپل سرمایهگذاری زیادی در آزمایشگاهها و تحقیقات هوش مصنوعی انجام دادند. هوش مصنوعی در مدلسازی زبان پیشرفت کرد و این پیشرفت در جیپیتی-۳، پذیرش گسترده ترجمه ماشینی مبتنی بر شبکه عصبی و سیستمهای پاسخگویی به پرسش به اوج خود رسید.

مدلهای مولد (دهه ۲۰۲۰): مدلهای زبانی بزرگ مانند جیپیتی-۳ و جیپیتی-۴ و هوش مصنوعی تولید کننده تصویر مانند دال-ای (DALL-E) یا استیبل دیفیوژن (Stable Diffusion) ارتباط فرهنگی هوش مصنوعی را تغییر دادهاند. افراد بدون پسزمینه برنامهنویسی اکنون میتوانند متون و تصاویر مختلف را با کلیک بر روی یک دکمه ایجاد کنند.

بهره گیری از تجربیات غولهای هوش مصنوعی پیشین

داستان هوش مصنوعی با شبکههای عصبی عمیق در دهه ۲۰۱۰ آغاز نشد. این کار با پرسشهای جسورانه و نمونههای اولیه کوچک افرادی آغاز شد که جرأت داشتند به این فکر کنند که آیا ماشینها میتوانند تواناییهای چشمگیر ذهن انسان را تقلید کنند یا خیر.

آلن تورینگ ما را به چالش کشید تا در مورد چگونگی اندازهگیری هوش در ماشینها فکر کنیم. جان مک کارتی این میدان را نامگذاری کرد و چارچوب منطقی را ساخت که هنوز زیربنای هوش مصنوعی نمادین است. ماروین مینسکی شکاف بین روانشناسی و محاسبات را پر کرد و در عین حال محدودیتهای مدلهای عصبی ساده را مشخص کرد. هربرت سایمون و آلن نیوول برخی از اولین برنامههای هوش مصنوعی را طراحی کردند که بازتاب حل مشکلات انسان بود.

آرتور ساموئل ثابت کرد که ماشینها میتوانند از تجربه یاد بگیرند. فرانک روزنبلات پرسپترون را معرفی کرد و بذر چیزی را کاشت که در نهایت به یادگیری عمیق تبدیل میشد.

این متفکران پیشگام نه تنها فناوریهای جدید را میساختند، بلکه نحوه مفهومسازی ما از هوش، شناخت و یادگیری را بازنگری میکردند. اگرچه هوش مصنوعی دورههای اوج و زمستانهای سرد را پشت سر گذاشته است، درک اصلی مبتکران اولیه همچنان در آن جاری است.

موفقیتهایی که اکنون شاهد آنها هستیم، از رباتهایی که با ما مکالمه میکنند تا آنهایی که در جهان حرکت میکنند، نشاندهنده روح تسلیمناپذیر کنجکاوی و خلاقیت انسان هستند که جرقهای برای آغاز کار هوش مصنوعی بوده است.

همانطور که پیشرفتهای بیشتر، توسعه وسایل نقلیه خودران، خلاقیت چندوجهی پیچیده و احتمالا سیستمهای فوق هوشمند را پیش رو داریم، باید به یاد داشته باشیم که حتی پیچیدهترین معماری یادگیری عمیق هم به آزمایشات با لولههای خلأ، نورونهای آنالوگ و سؤالهای اساسی و اولیه پرسیده شده توسط دانشمندان بازمیگردد.

انتهای پیام

نظرات